DeepSeek, сейчас на пике своей популярности. В России для использования не нужна ни оплата, ни VPN, что удобно, кроме этого он обладает следующими преимуществами:

Открытый код. Любой может развернуть и использовать по своему назначению, не отправляя свои вопросы во вне, не обучая чужие модели.

Работает быстрее на тех же мощностях, что конкуренты. Заявляют, что разница очень существенная.

DeepSeek без проблем можно установить на своё железо с помощью Ollama. Это бесплатная платформа для запуска различных моделей ИИ локально. Она уже поддерживает DeepSeek, так что установка очень простая.

Требования к железу:

- ПРОЦЕССОР: современный x86-64 или ARM (Apple Silicon).

- Графический процессор (опционально): NVIDIA (CUDA), AMD (ROCm) или Apple Metal.

В этом руководстве я покажу вам, как всего за несколько минут установить чат DeepSeek AI на вашем домашнем сервере и начать использовать его локально совершенно бесплатно и без ограничений. Это руководство предполагает, что у вас уже есть домашний сервер с установленными Docker и Portainer.

Cервер с Docker и Portainer

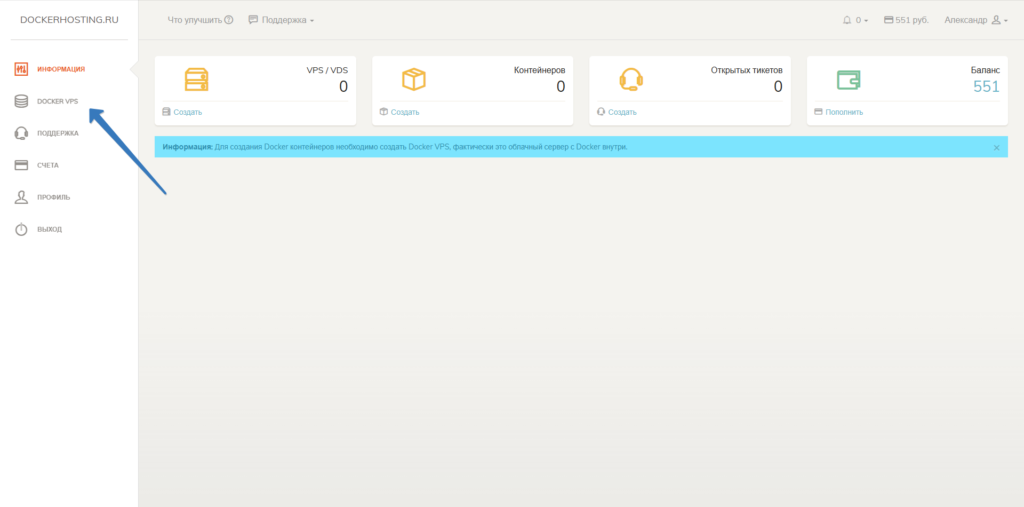

Если у вас еще нет сервера для развертки LLM модели ИИ, то зарегистрируйте в личном кабинете и создайте сервер в разделе Docker VPS.

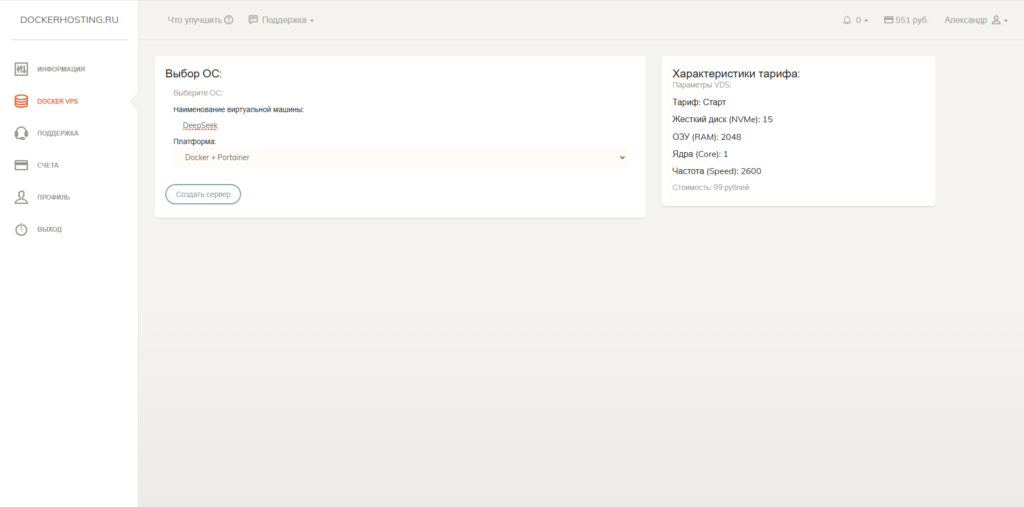

Выберете тариф и укажите название сервера.

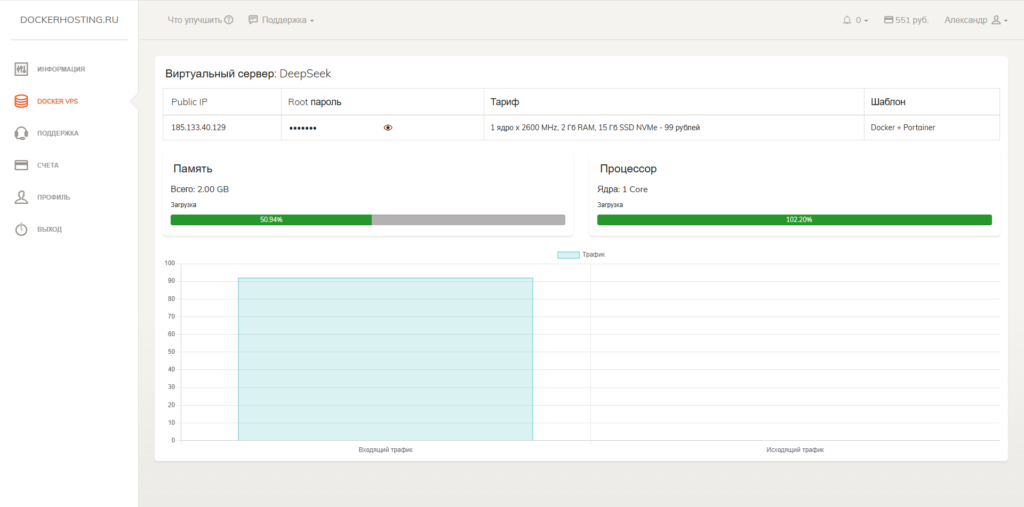

Через минуту мы получим готовый сервер с предустановленным Docker и Portainer.

Далее проверяем почту, чтобы получить данные для авторизации на сервере и в Portainer.

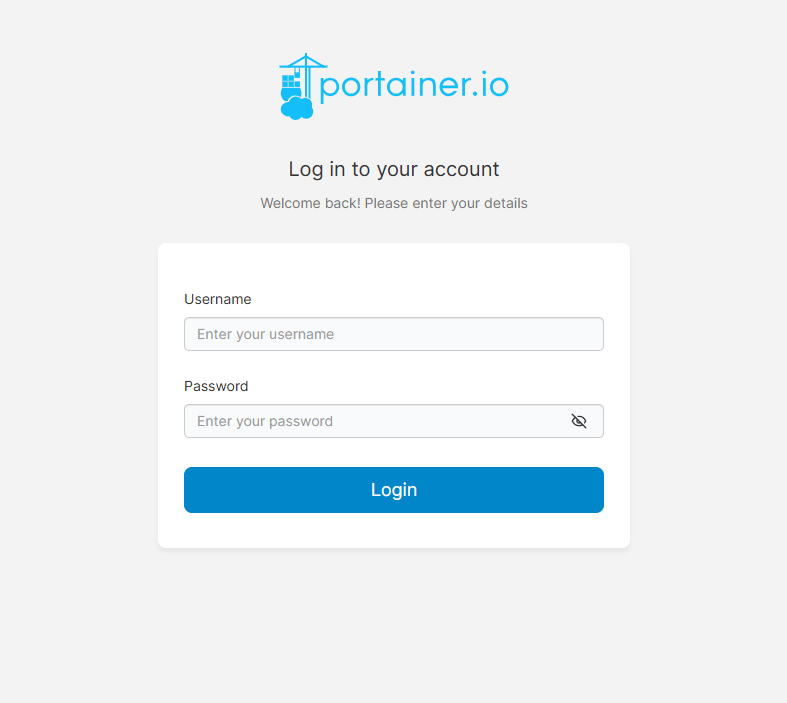

Переходим в Portainer по ссылке из письма и авторизуемся в нем, теперь можно приступать непосредственно к развертке и запуску DeepSeek.

Запуск DeepSeek с помощью Portainer

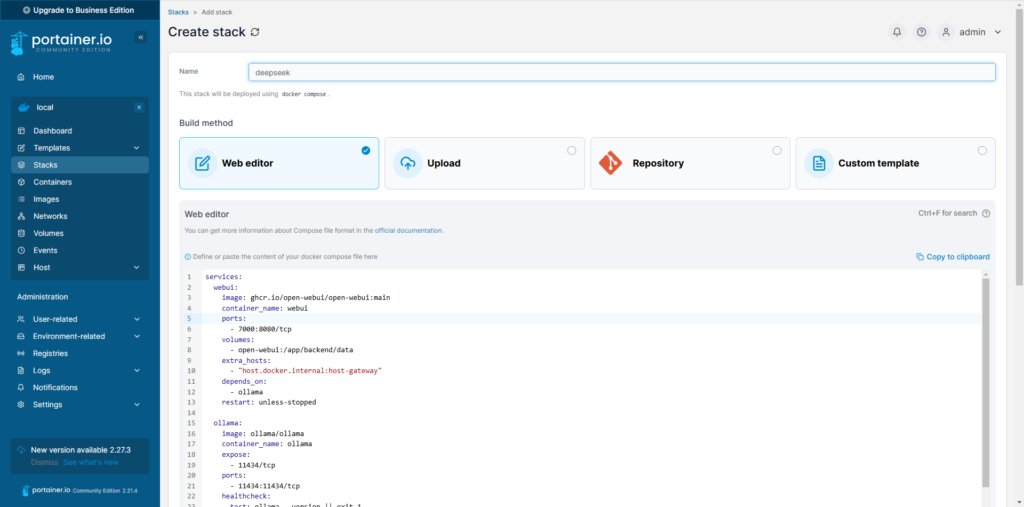

Чтобы ускорить процесс воспользуемся оболочкой Portainer, создадим новый стек в Portainer и вставим содержимое файла docker-compose.yml, для этого:

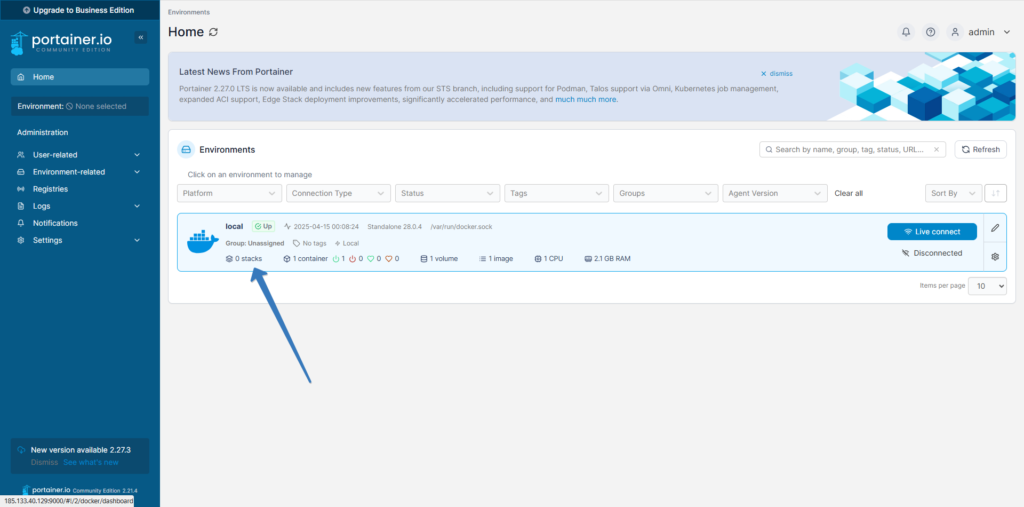

Выберем окружение, как на рисунке нижк

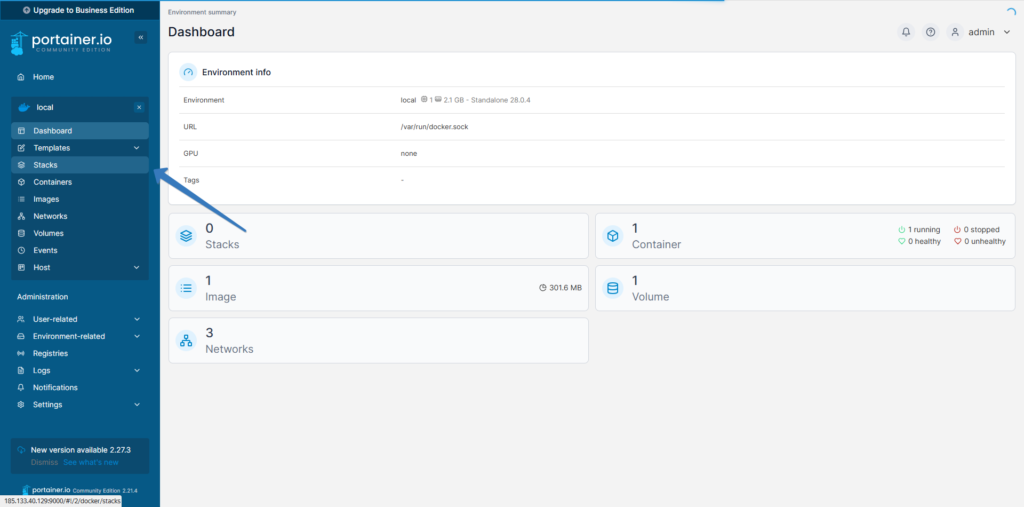

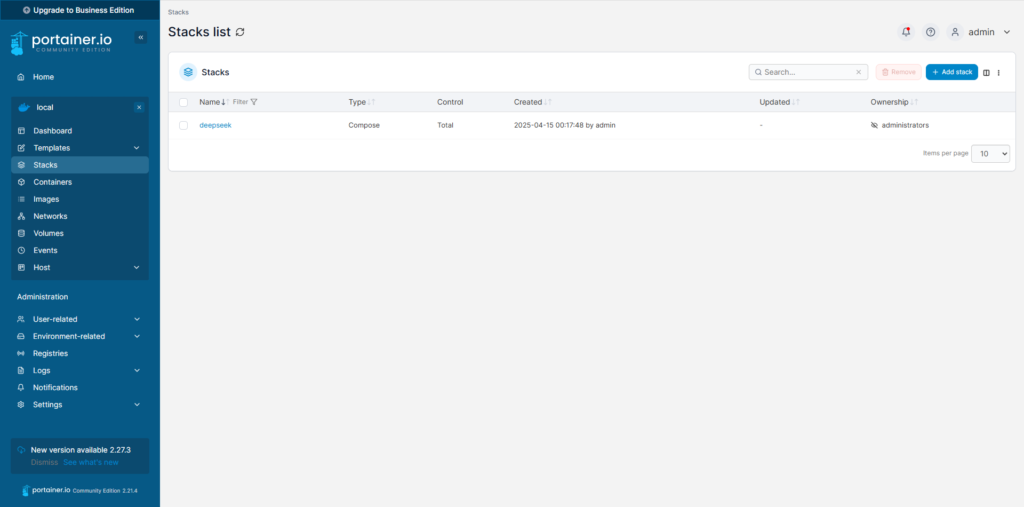

Выберем раздел Stacks

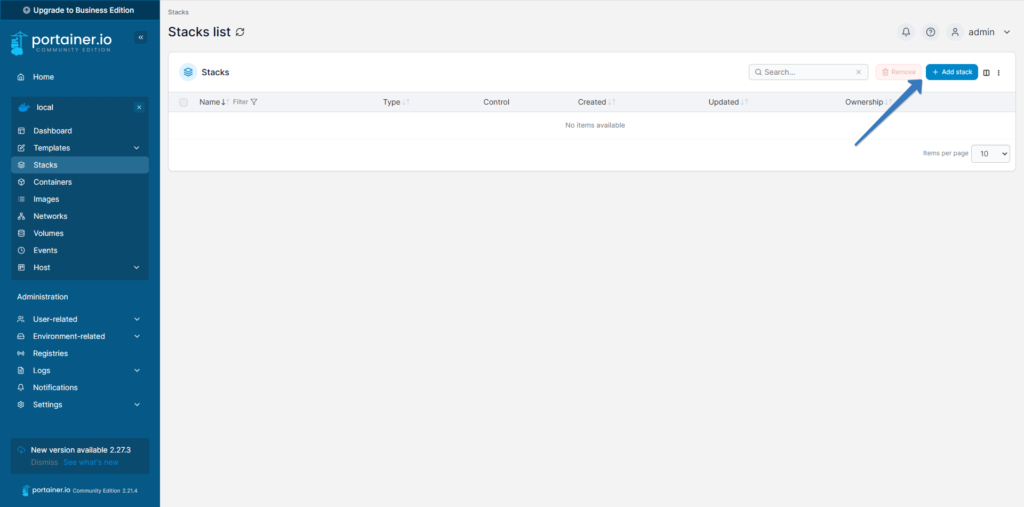

Добавить Stack

Добавим следующий код в создаваемый Stack

services:

webui:

image: ghcr.io/open-webui/open-webui:main

container_name: webui

ports:

- 7000:8080/tcp

volumes:

- open-webui:/app/backend/data

extra_hosts:

- "host.docker.internal:host-gateway"

depends_on:

- ollama

restart: unless-stopped

ollama:

image: ollama/ollama

container_name: ollama

expose:

- 11434/tcp

ports:

- 11434:11434/tcp

healthcheck:

test: ollama --version || exit 1

volumes:

- ollama:/root/.ollama

restart: unless-stopped

volumes:

ollama:

open-webui:

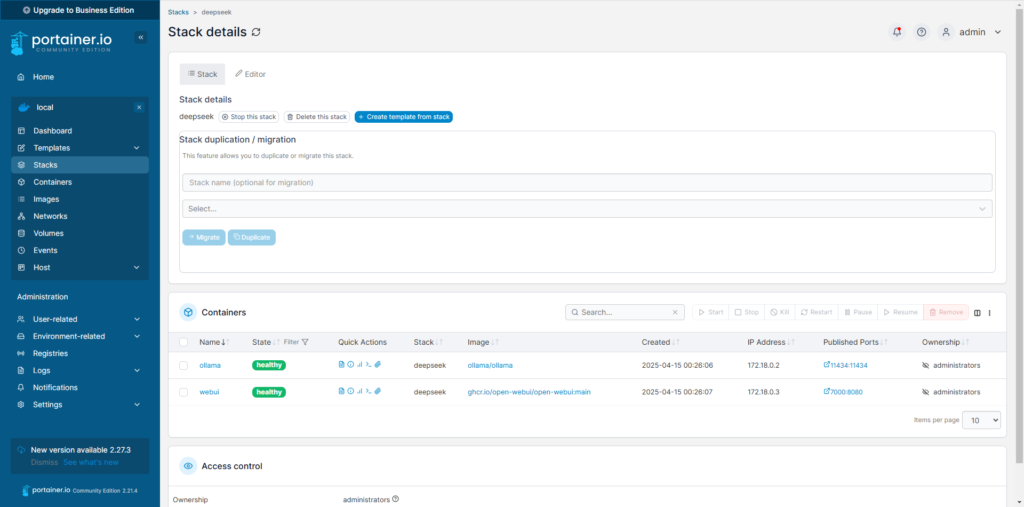

Нажмите «Deployment Stack» и дождитесь установки и запуска сервисов, не забудьте указать название Stack. Эта настройка установит два контейнера:

- Ollama — серверная служба, которая локально запускает и управляет большими языковыми моделями (LLM).

- WebUI — удобный веб-интерфейс, который позволяет легко взаимодействовать с Ollama.

После установки и запуска обоих контейнеров вы можете получить доступ к веб-интерфейсу, открыв:

http://имя_хоста_или_IP:7000 в вашем браузере.

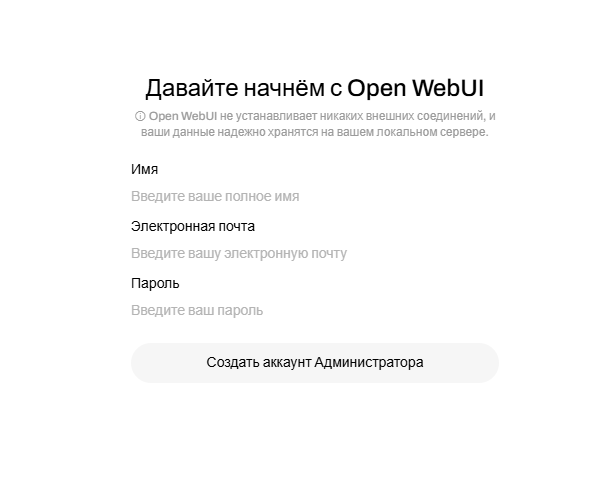

Использование WebUI

На странице WebUI вам сначала будет предложено создать учётную запись администратора. Вы можете ввести любые учётные данные, которые вам нравятся, — они никуда не будут передаваться и будут храниться локально на вашем сервере.

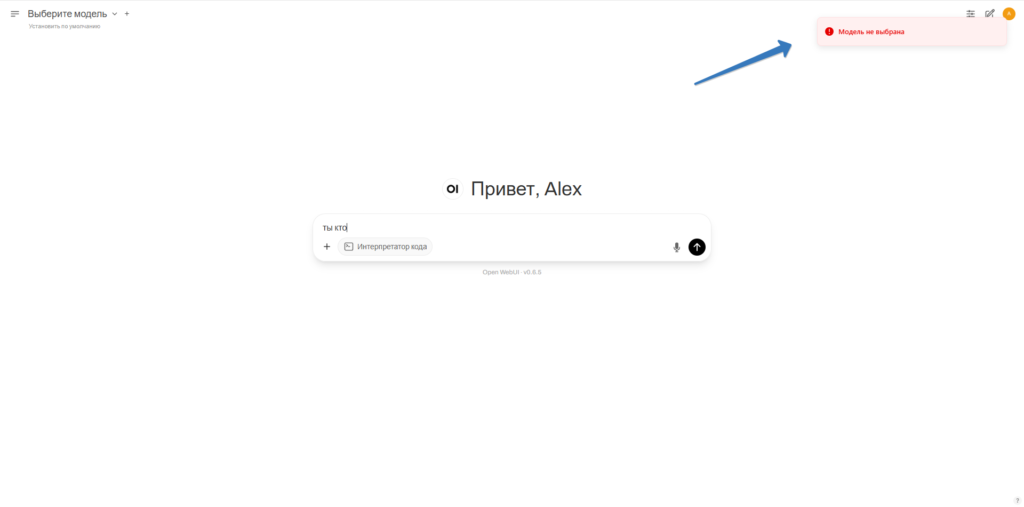

Загрузка модели DeepSeek

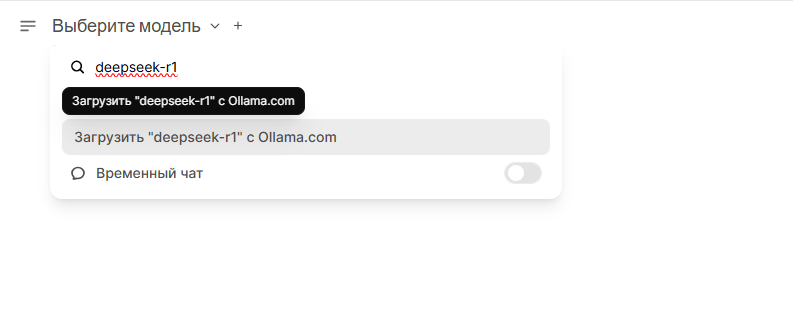

- Перейдите на вкладку «Рабочая область». Нажмите на стрелку вниз рядом с «Выбрать модель».

- Введите в поиске:

- «deepseek-r1» для модели 7b или

- «deepseek-r1:1.5b» для модели 1.5b.

- Нажмите «Скачать ‘deepseek-r1’ с сайта Ollama.com», чтобы загрузить выбранную модель.

Вот и всё! Как только модель будет загружена, вы сможете начать пользоваться местным чатом DeepSeek AI!

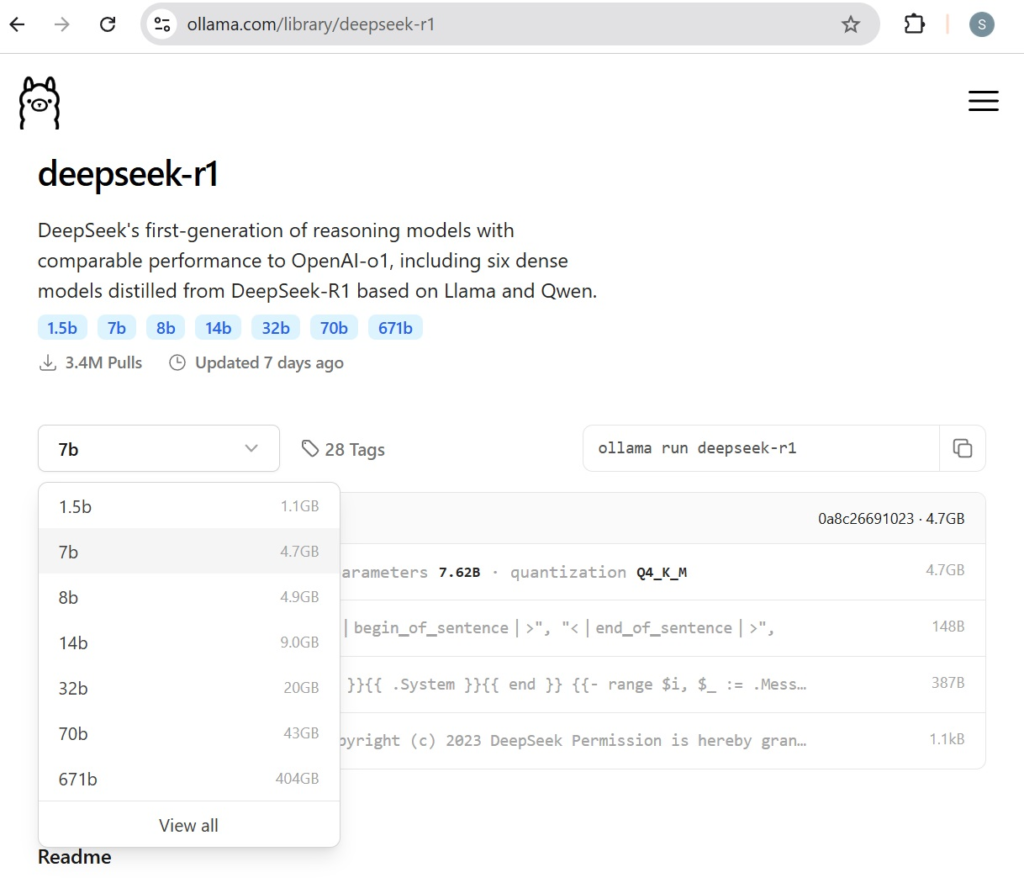

Вы можете выбрать одну из различных версий модели DeepSeek в зависимости от имеющегося у вас оборудования. Вот несколько примеров:

- deepseek-r1:1.5b — самая компактная модель, для работы которой требуется 1,2 ГБ дискового пространства и 1,5 ГБ свободной оперативной памяти.

- deepseek-r1:7b — более крупная модель, для которой требуется 4,7 ГБ дискового пространства и 5,5 ГБ оперативной памяти.

- deepseek-r1:671b — самая продвинутая из доступных на данный момент полных моделей, требующая 405 ГБ дискового пространства и примерно столько же оперативной памяти.

Полный список моделей DeepSeek смотрите здесь: модели DeepSeek на Ollama.

Вы можете загрузить несколько моделей и переключаться между ними так же, как в веб-интерфейсе Chat GPT.

Кроме того, не стесняйтесь изучать другие модели, не относящиеся к DeepSeek, доступные в библиотеке Ollama.

Ссылки на источники: